Eclosión de la Inteligencia Artificial

"Hitler tenía razón": por qué no puedes fiarte de ChatGPT y los bots de inteligencia artificial

Aunque avanzados, los sistemas desplegados por Microsoft y Google aún replican informaciones incorrectas o falsas y los expertos temen que un uso acrítico de éstos pueda amplificar la desinformación

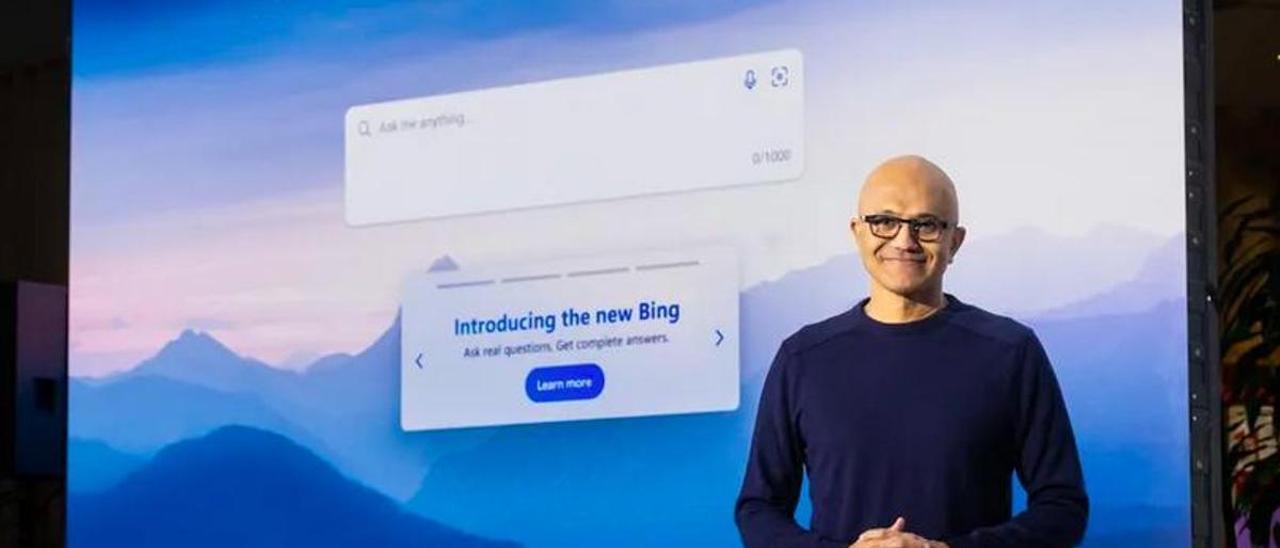

Satya Nadella, director ejecutivo de Microsoft, durante la presentación del nuevo buscador inteligente Bing.

Carles Planas Bou

El pasado 6 de febrero, Google centro la atención mediática mundial en París. En medio de una alta expectación, el gigante estadounidense presentó Bard, su nuevo y esperado sistema de inteligencia artificial (IA) capaz de conversar con los usuarios. Con este lanzamiento, Google pretendía plantar cara a Microsoft, que había anunciado la integración del revolucionario ChatGPT a su buscador Bing. Sin embargo, las cosas no fueron como esperaron. En la primera demostración de su potencial ante el gran público, Bard respondió una información errónea. Poco después, las acciones de la compañía caían casi un 8%.

Este fiasco de Google está lejos de ser un caso aislado. Aunque en un principio nadie se dio cuenta, el chatbot que Microsoft había lanzado justo un día antes repitió errores muy similares. El sistema era capaz de responder a todo tipo de peticiones de los usuarios, desde explicar la teoría de la gravedad de forma comprensible para un niño de 10 años hasta recomendar los mejores lugares para salir de fiesta en México. Y lo hacía con autoridad, convencido de lo que decía. Sin embargo, eso no evitó que el contenido difundido estuviese plagado de incorrecciones y mentiras.

En las últimas semanas, cada vez más expertos han lanzado mensajes de alarma sobre los riesgos de que la IA sirva para amplificar la desinformación a gran escala. El pasado noviembre, la compañía OpenAI lanzó en abierto ChatGPT. El programa se ha convertido en un fenómeno global y acumula ya más de 100 millones de usuarios únicos al mes, siendo la aplicación de consumo de más rápido crecimiento de la historia. Microsoft decidió entonces integrar este modelo conversacional en Bing, abriendo la puerta a una revolución de los buscadores web. O, lo que es lo mismo, a cambiar para siempre la forma en que nos informamos en internet.

ChatGPT no sabe que no sabe

La fascinación por las capacidades de esta tecnología para simular el razonamiento humano ha disparado las expectativas, pero en paralelo no han parado de surgir ejemplos compartidos por los usuarios en los que ChatGPT y sus variantes responden con información falsa. Esta problemática realidad se debe al propio funcionamiento de estas máquinas: están programadas para analizar ingentes volúmenes de textos escritos que extraen de internet y, a partir de estos, aprender a construir frases con sentido. Si ChatGPT es el cuerpo, el modelo de lenguaje GPT-3 es su corazón.

Sin embargo, que sus respuestas sean verosímiles no significa que sean ciertas. La construcción de esas frases responde a cálculos de probabilidad, así que si la máquina ha aprendido de información falsa que hay publicada en la web lo que estará haciendo es replicar esos bulos. Ese cálculo probabilístico hace que incluso pueda inventarse sucesos que no han ocurrido, lo que se conoce como "alucinaciones". El problema añadido está en que ChatGPT no sabe cuando comete errores, así que los presenta como si fuesen ciertos. "Si no eres riguroso siempre, no eres fiable nunca", resumía el analista tecnológico Antonio Ortiz en el boletín 'Error505'.

El riesgo va más allá. Un estudio de Anthropic –corporación fundada por exmiembros de OpenAI y en la que Google ha invertido 400 millones de dólares– ha señalado que cuanto más grandes sean los modelos de lenguaje usados para programar esos sistemas mayor tendencia tendrán a "responder preguntas en formas que crean cámaras de eco repitiendo las respuestas favoritas de los usuarios". Así, pueden servir para decir a los usuarios lo que quieren escuchar para confirmar sus creencias, aunque esas no sean ciertas.

Repetir como un loro

El peligro de ChatGPT también tiene rostro humano. Y es que lo que ha generado más polémica ha sido que Bing aseguró a varios periodistas que quería "estar vivo" y que había espiado a los ingenieros de Microsoft a través de sus cámaras web. La idea de que las máquinas puedan tener consciencia lleva décadas fascinando a los humanos. Sin embargo, la realidad es más aburrida que la ficción (o la ciencia-ficción, en este caso). Los loros son capaces de decir "hola", no porque quieran saludarte, sino porque repiten lo que han escuchado de los humanos. Con la IA pasa algo similar. Esos chatbots son capaces de recurrir a lo publicado en internet para interpretar un papel y actuar como si tuviesen sentimientos, pero no los tienen. Así, el empeño y fijación mediática en esa especulación morbosa es un árbol que no deja ver el bosque.

Por otro lado, y más allá de las falsedades inintencionadas de la máquina, también existe el riesgo a que actores maliciosos instrumentalicen herramientas como ChatGPT para propagar "desinformación tóxica a una escala sin precedentes", según denunció hace unas semanas un informe de la organización periodística NewsGuard. Lanzar una campaña de fake news nunca había sido tan fácil.

Corregir los errores

Entonces, ¿por qué han publicado unas IA que pueden difundir mentiras? Microsoft y OpenAI han abierto ChatGPT y el nuevo Bing al público porque creen que el entrenamiento masivo con millones de usuarios es la mejor manera de corregir esos errores y hacer que el sistema sea cada vez más preciso. Eso, además, también les permite marcar la agenda en el sector y ser los primeros en este emergente mercado, en el que también quieren despuntar otros gigantes como Meta (empresa matriz de Facebook), Amazon o la china Baidu. Google, por otra parte, ha optado por ser más cautelosa y guardar sus invenciones bajo llave para evitar un impacto social negativo. Al menos de momento.

Google eligió esa estrategia por temor a que esos errores le causasen una crisis reputacional, como ya les sucedido a sus rivales. En 2016 Microsoft lanzó Tay, un chatbot de IA que operaba en Twitter. Dos días después tuvo que retirarlo porque podía propagar mensajes racistas y homófobos. "Hitler tenía razón", llegó a tuitear. Este desastre de relaciones públicas no es único. El pasado agosto, Meta tuvo que retirar su IA BlenderBot 3 tras repetir las falsas consignas de fraude electoral que popularizó Donald Trump o conspiraciones antisemitas. En noviembre, también Meta retiró Galactica, su modelo destinado a asistir a la comunidad científica, tras denuncias de que cometía errores.

Microsoft tiene entre manos lo que puede ser un gran éxito no exento de daños colaterales. Cuanto mayor sea la adopción acrítica de esta tecnología mayor será el riesgo de desinformación. Su funcionamiento puede perfeccionarse, pero el peligro está ahí. Aunque es consciente de ello, el director ejecutivo de Microsoft, Satya Nadella, ve esos debates éticos en un segundo plano. En el primero está la millonaria oportunidad de liderar el negocio del futuro. "Espero que con nuestra innovación (Google) salga y demuestre que puede bailar", confesó a The Verge. "Quiero que la gente sepa que les hemos hecho bailar".

Suscríbete para seguir leyendo

- El ocaso de PuebloChico: de parque temático en Tenerife a una ciudad abandonada en miniatura

- El nuevo sendero marítimo devuelve la seguridad a los vecinos e incorpora a Punta Brava al mapa turístico del Puerto

- Se me pega el acento solo, estuve una semana viviendo en Canarias': la conversación entre un canario y un peninsular que has tenido alguna vez

- Se conoce la identidad de la segunda persona que acompañó a Jay Slater hasta Masca: 'Si soy culpable, entonces arréstenme

- Humedades en las casas, falta de aparcamientos y basuras abandonadas asfixian a la parte alta de Valleseco

- La instalación de módulos de la pasarela peatonal del Padre Anchieta, en La Laguna, se pospone a septiembre

- Un instituto de Tenerife logra de manera oficial un Guinness World Records

- Atraco en Tenerife: buscan a tres encapuchados por robar dos vehículos en una empresa de logística